Установка счетчика Яндекс.Метрики

Яндекс.Метрика — это инструмент веб-аналитики, который помогает получать наглядные отчеты, видеозаписи действий посетителей, отслеживать источники трафика и оценивать эффективность онлайн- и офлайн-рекламы.

Внимание

Если ваш сайт создан на Конструкторе Рег.ру, установите счетчик по инструкции: Продвижение сайта, созданного в Конструкторе Рег.ру.

Чтобы установить счетчик Яндекс.Метрики на сайт:

- 1 Авторизуйтесь на странице Яндекс.Метрика или зарегистрируйтесь.

-

2

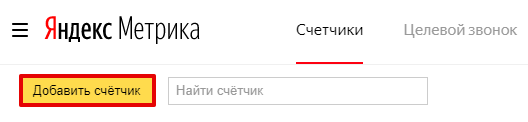

Нажмите Добавить счетчик:

-

3

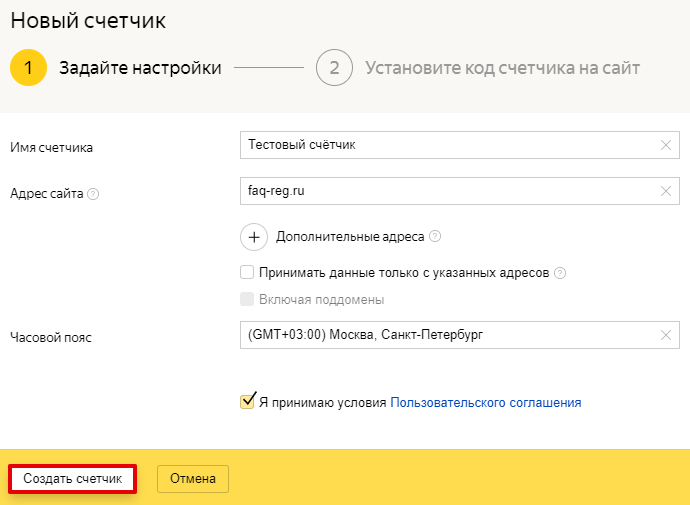

На открывшейся странице введите:

- Имя счётчика;

- Адрес сайта (основной домен сайта);

- Часовой пояс.

Примите условия Пользовательского соглашения и нажмите Создать счетчик:

-

4

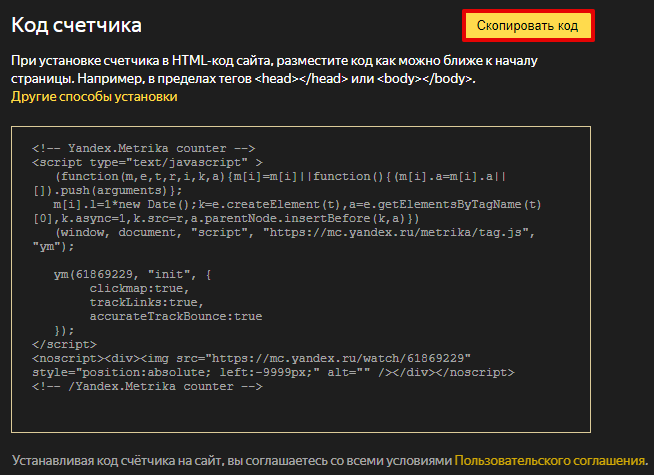

Скопируйте код счетчика. Нажмите кнопку Скопировать код:

-

5

Добавьте этот код в HTML-код всех страниц сайта.

Обратите внимание: способ, которым можно добавить HTML-код на страницы, зависит от структуры сайта. Если у вас возникают сложности, обратитесь к разработчикам сайта.

Готово, вы добавили счетчик Яндекс.Метрики. Теперь вы сможете отслеживать статистику по посетителям вашего сайта.

Важно: Специалисты компании Рег.ру не оказывают поддержки по установке счетчика.

Подробнее процесс установки счетчика и дополнительных метрик для сбора статистики описан в руководстве на официальном сайте Яндекс.

Помогла ли вам статья?

Спасибо за оценку. Рады помочь 😊

Статистика AWStats, Webstat

AWStats (Advanced Web Statistics) — программа для визуализации статистики, которая генерирует наглядные отчеты по:

- посещаемости сайта,

- уникальным посетителям,

- наиболее популярным разделам сайта,

- продолжительности визитов,

- количеству кликов,

- ключевым словам, благодаря которым пользователи нашли ваш сайт и многое другое.

Ниже описана работа с AWStats в панелях управления ispmanager, Parallels Plesk, cPanel.

Войдите в панель управления и следуйте дальнейшим инструкциям в зависимости от используемой панели.

ispmanager

На хостинге с панелью управления ispmanager присутствует инструмент веб-аналитики «AWStats».

Не следует путать его с «Webstat». webstat это папка, в которой хранятся логи «AWStats», и путь (URL), по которому доступна статистика сайта. Например: ваш-сайт.ru/webstat.

Как включить сбор статистики

-

1

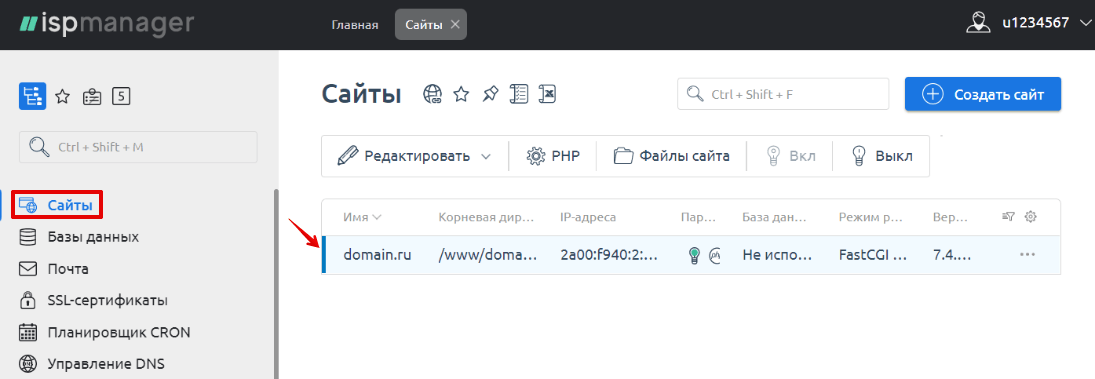

Перейдите в раздел Сайты и кликните два раза на домен, чтобы выбрать его:

-

2

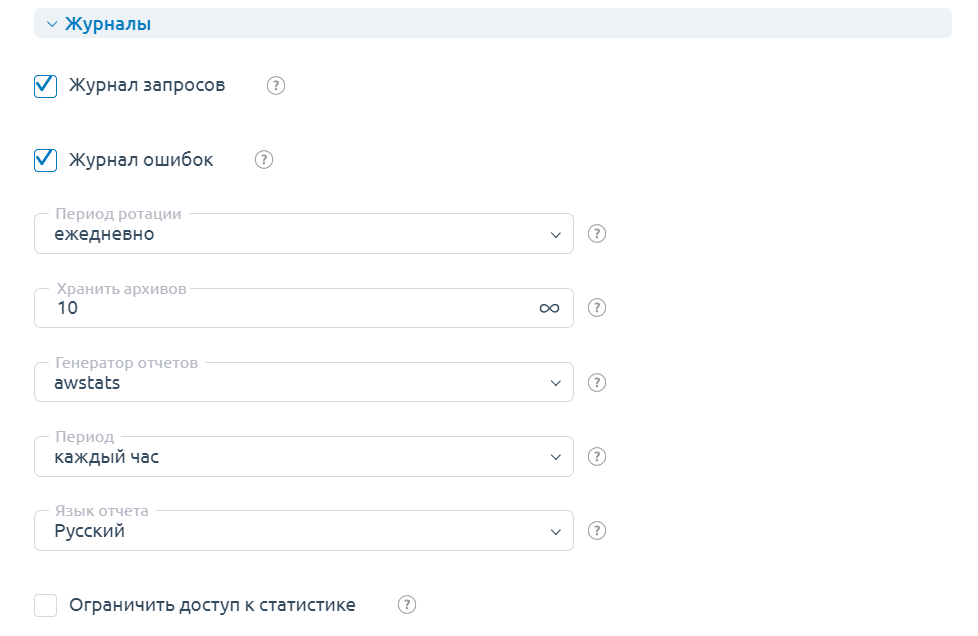

В открывшемся окне настроек найдите блок Журналы и выставьте параметры в соответствии со скриншотом:

Внимание! В панели управления ispmanager 6 ротацию логов нужно настраивать вручную для каждого домена.

-

3

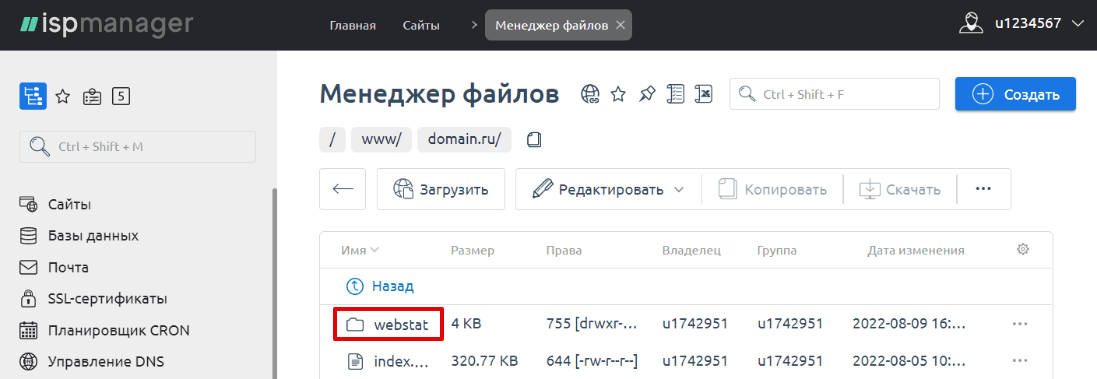

Нажмите ОК, чтобы сохранить изменения. В корневом каталоге сайта появится директория webstat:

Данную директорию нельзя удалять, иначе сбор статистики перестанет работать корректно.

Как просмотреть статистику сайта

Чтобы просмотреть статистику сайта, перейдите по следующему URL: ваш-сайт.ru/webstat. Если браузер запросит ввод логина и пароля, введите ваш логин хостинга (вида u1234567) и стартовый пароль к нему. Логин и пароль можно узнать в стартовом письме, высланном на контактный e-mail при заказе хостинга и в личном кабинете в разделе Информация о включённых сервисах и паролях доступа.

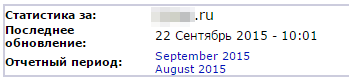

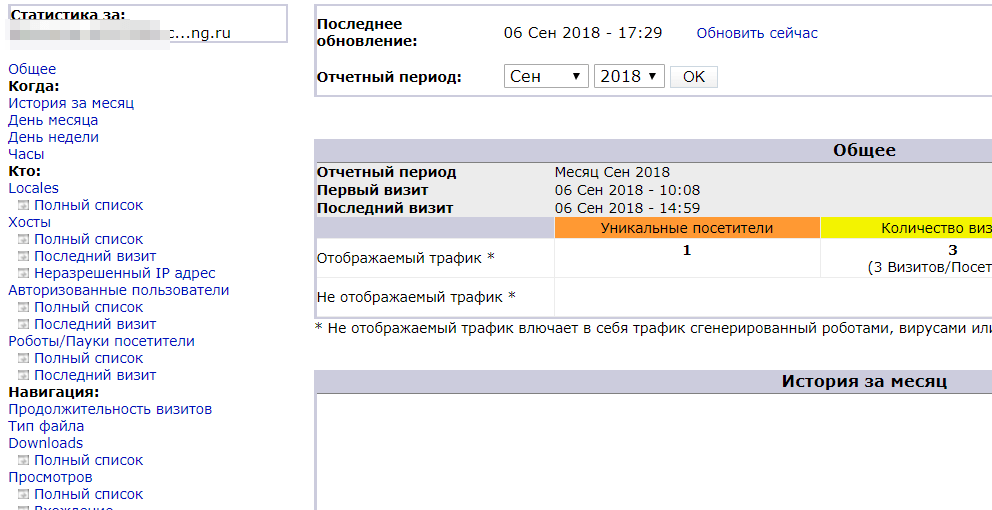

При входе в статистику вы увидите подобную страницу:

Выберите отчетный период и приступите к анализу статистики.

Не можете попасть в статистику сайта?

- 1 Проверьте, существует ли директория webstat в папке сайта. Если директория отсутствует, настройте ротацию логов по инструкции выше (Как включить сбор статистики?);

- 2 Если директория webstat присутствует, но при переходе в статистику вы видите 403 ошибку, значит статистика ещё не собралась. Вам просто нужно подождать. Если вы настроили ротацию логов по инструкции выше, статистика станет доступной в течение часа.

cPanel

Обратите внимание: если вид вашей панели управления отличается от представленного в статье, в разделе «Основная информация» переключите тему с paper_lantern на jupiter.

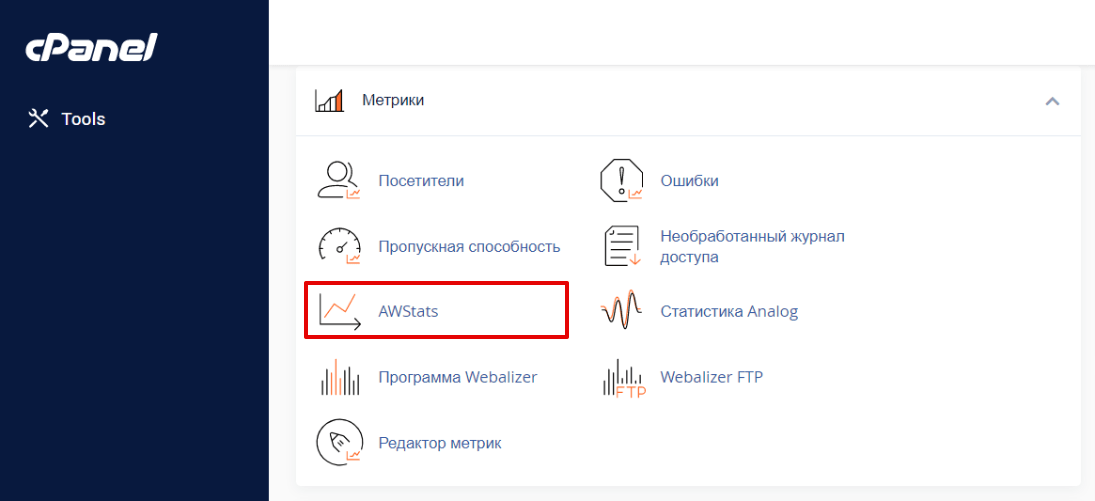

В панели управления cPanel сбор статистики включен по умолчанию. Чтобы посмотреть статистику сайта:

-

1

Пролистайте страницу вниз до раздела «Метрики» и кликните по значку AWStats:

-

2

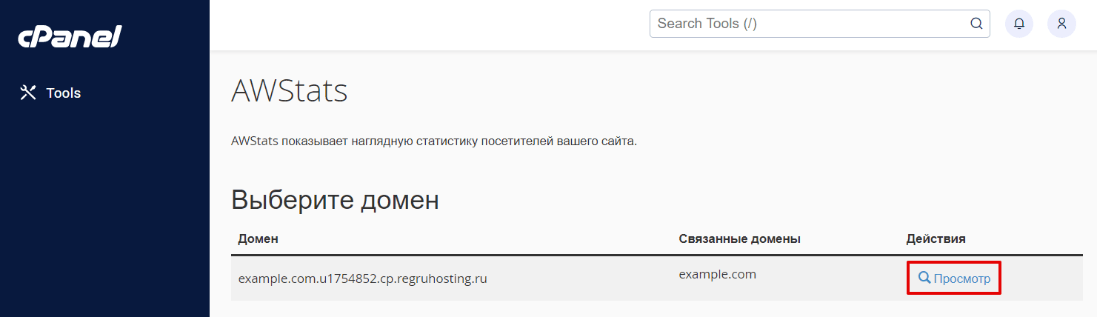

Выберите в списке домен, статистику которого вы хотите узнать, и нажмите напротив него Просмотреть:

-

3

В новой вкладке будет отображаться статистика посещений сайта:

Plesk

В панели управления Parallels Plesk сбор статистики включен по умолчанию. Чтобы посмотреть статистику сайта:

-

1

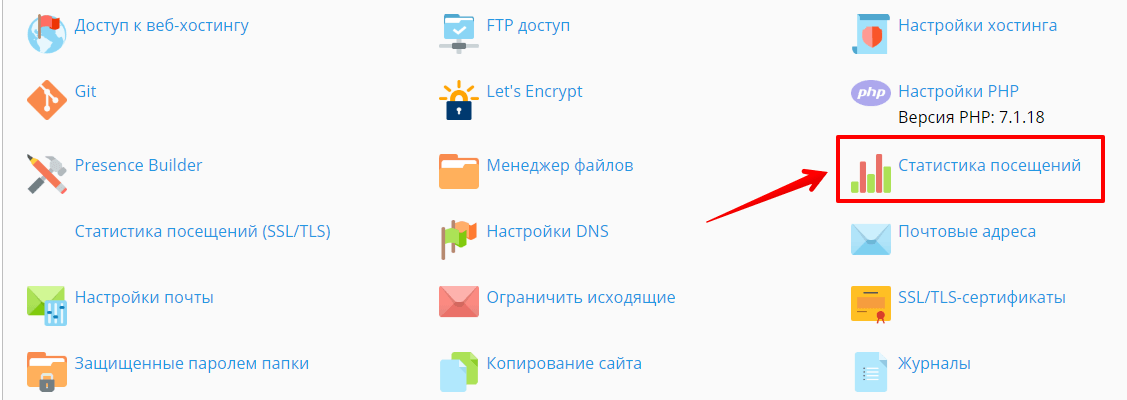

Откройте страницу «Сайты и домены» и выберите сайт, статистику посещений которого вы хотите посмотреть. Затем кликните на иконку Статистика посещений:

-

2

В открывшемся окне авторизации введите логин хостинга (u1234567) и пароль, нажмите Вход.

Логин и пароль услуги хостинга

Данные для входа вы можете узнать по инструкции Информация о включенных сервисах и паролях доступа.

-

3

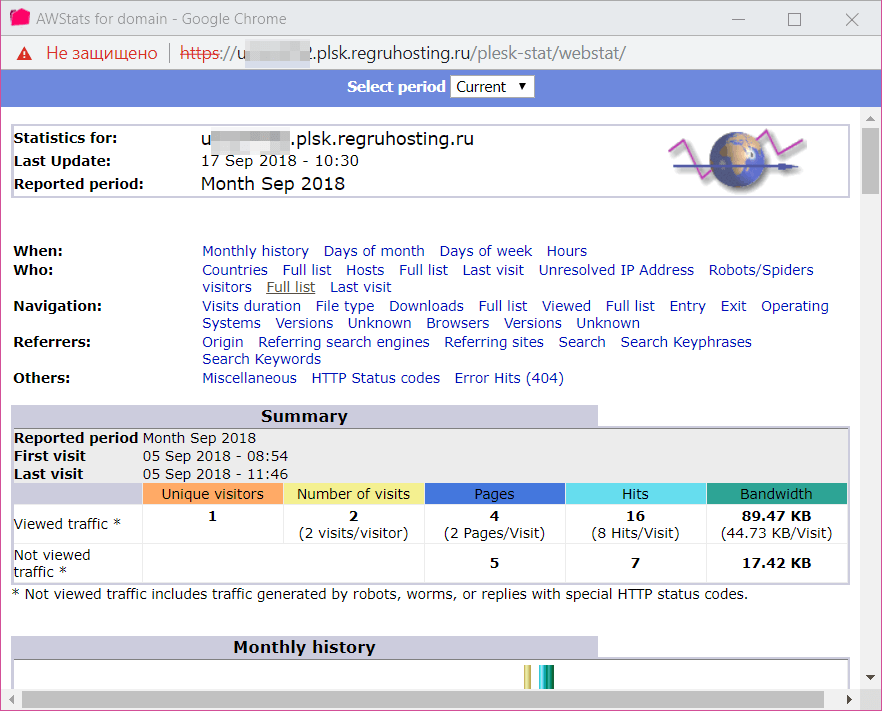

После авторизации вы перейдете к статистике:

Помогла ли вам статья?

Спасибо за оценку. Рады помочь 😊

Что сделать, чтобы мой сайт видели поисковые системы

В этой статье мы расскажем, как добавить сайт в поисковые системы: как проиндексировать сайт в Яндексе и добавить сайт в поиск Google.

После публикации сайта позаботьтесь о том, чтобы пользователи могли найти его в Интернете. Если пользователь знает URL-адрес сайта, сделать это легко. Сложнее сделать так, чтобы сайт быстро находился через поисковые системы.

Возникает закономерный вопрос: «Я уже создал сайт, как его разместить в Интернете?». Это связано с индексацией сайта. Прежде чем понять, как добавить свой сайт в поисковики Яндекс и Google, разберемся, что такое индексация.

Что такое индексация

Индексация сайта — это добавление его страниц в базу поисковых систем (поиск в Яндекс, Google, Рамблер, Yahoo, Mail, Bing и т.д.). Чтобы проиндексировать веб-страницы, поисковики отправляют на обход специальных роботов. Они анализируют HTML-код сайтов, учитывая:

- правильное наполнение страниц метатегами (description, title, keywords, h1, p) и их соответствие стандартам вёрстки;

- грамотное расположение текста;

- перелинковку;

- наличие карты сайта (sitemap);

- микроразметку.

В результате проверки роботы индексируют сайт, и он начинает отображаться в поисковой выдаче. Как добавить сайт на индексацию в поисковики, читайте ниже.

Почему сайта нет в Yandex и Google

Процесс индексации может занимать несколько недель. Представьте, какое количество новых сайтов нужно обойти роботам. Кроме того, не все страницы одного сайта индексируются одновременно. А если в коде есть то, что не удовлетворяет требованиям поисковых систем, индексация затянется.

Если вы только что разместили сайт в Интернете, он не будет сразу же отображаться в Яндекс и Google. Если вам нужно, чтобы сайт как можно быстрее отображался в поисковой выдаче, ускорьте индексацию вручную.

Ниже рассмотрим, как бесплатно добавить сайт на индексацию в поисковики.

Как ускорить процесс индексации сайта

Как сделать так, чтобы сайт стал быстрее видимым для поисковых систем? Нужно самому указать на свой сайт Яндекс и Google. Это делается через специальные панели, предназначенные для разработчиков сайтов: Яндекс.Вебмастер и Google Search Console. Прежде чем следовать инструкции о том, как разместить сайт в Гугл и в Яндекс, авторизуйтесь в нужной системе.

Как добавить сайт в Яндекс.Вебмастер

Чтобы добавить сайт в поисковую систему Яндекс, следуйте инструкции ниже:

- 1 Перейдите на страницу Яндекс.Вебмастера.

- 2 Перейдите по ссылке Добавить сайт.

-

3

Введите адрес сайта (доменное имя) и нажмите Добавить:

Размещение сайта в Яндекс.Webmaster

-

4

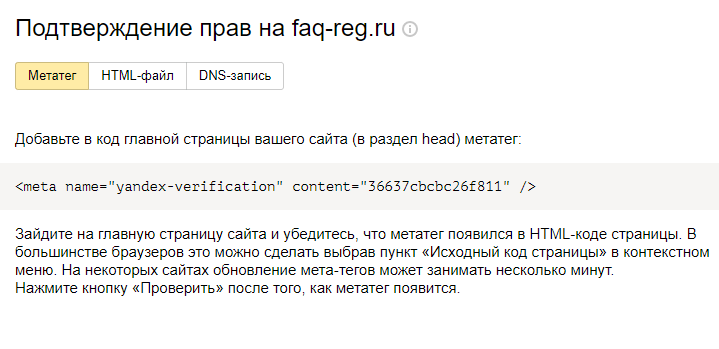

Подтвердите права на сайт. Сделать это можно через:

- код-страницы (Метатег);

- загрузку файла на хостинг (HTML-файл);

- или добавление TXT-записи (DNS-запись).

Мы рекомендуем добавить DNS-запись, так как это наиболее простой способ.

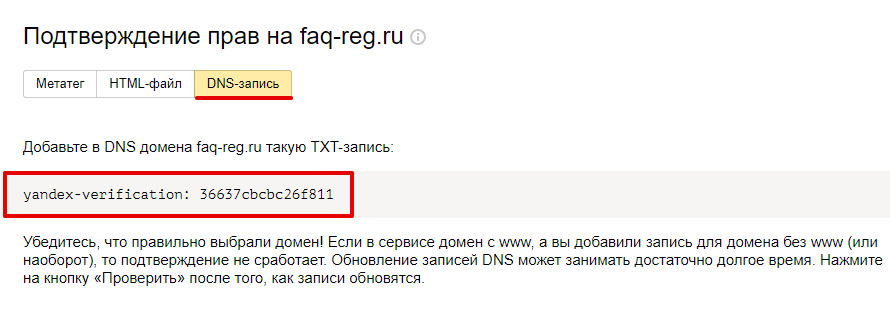

Как добавить DNS-запись для подтверждения прав

Кликните по вкладке «DNS-запись» и скопируйте значение TXT, которое нужно добавить:

Яндекс.Вебмастер: подтверждение прав на сайт

Определите, какие DNS-серверы прописаны для домена, по инструкции. От этого будет зависеть, где добавить TXT-запись:

- если для домена указаны ns1.reg.ru и ns2.reg.ru, воспользуйтесь пошаговой инструкцией раздела «Помощь»;

- если для домена указаны ns1.hosting.reg.ru и ns2.hosting.reg.ru, воспользуйтесь статьей.

Дождитесь обновления зоны домена.

Готово, вы добавили TXT-запись для подтверждения права на домен.

-

5

После подтверждения прав нажмите Проверить. Если права подтверждены корректно, вы увидите следующее:

как добавить сайт в поиск яндекса

После мы рекомендуем воспользоваться инструментом Переобход страниц. Через него можно задать, какие страницы сайта стоит проиндексировать в первую очередь.

Готово, вы ускорили индексацию сайта. Теперь вы знаете, как добавить сайт в Вебмастер.

Обратите внимание

Описанный способ не требует технических навыков и знания SEO-оптимизации, но не гарантирует, что сайт сразу появится в поисковой выдаче. Если вы технически подкованы, воспользуйтесь другим способом: Как добавить сайт в поиск Яндекса.

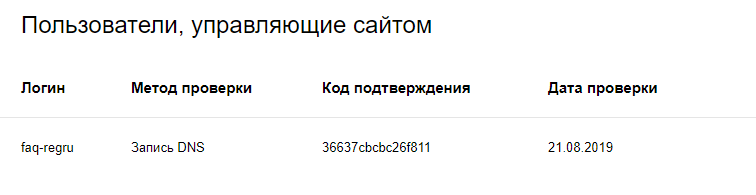

Как добавить сайт в поиск Google

Как разместить сайт в Гугле, вы узнаете по инструкции:

- 1 Перейдите на страницу Google Search Console.

-

2

Введите адрес сайта в первом блоке и нажмите Продолжить:

Как добавить url в поисковые системы

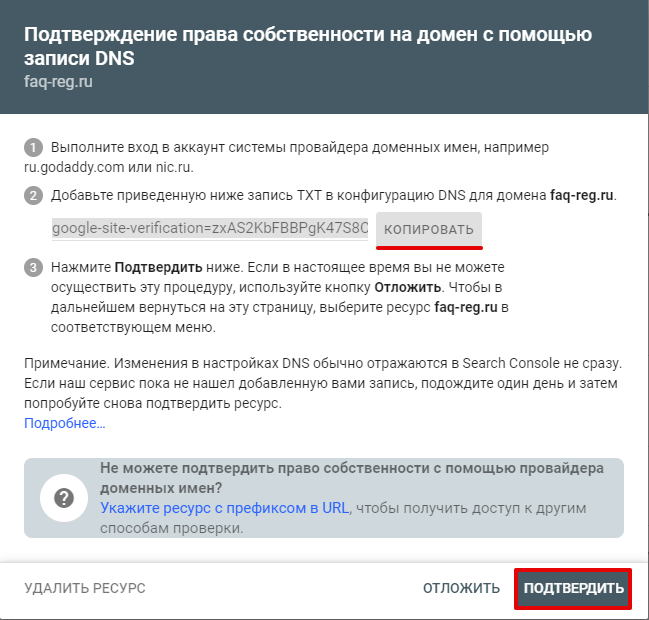

- 3 Добавьте нужную запись в зону домена по инструкции ниже и нажмите Подтвердить.

Как добавить DNS-запись для подтверждения прав

Скопируйте значение TXT-записи.

Определите, какие DNS-серверы прописаны для домена, по инструкции. От этого будет зависеть, где добавить TXT-запись:

- если для домена указаны ns1.reg.ru и ns2.reg.ru, воспользуйтесь пошаговой инструкцией раздела «Помощь»;

- если для домена указаны ns1.hosting.reg.ru и ns2.hosting.reg.ru, воспользуйтесь статьей.

Дождитесь обновления зоны домена.

Готово, вы добавили TXT-запись для подтверждения права на домен.

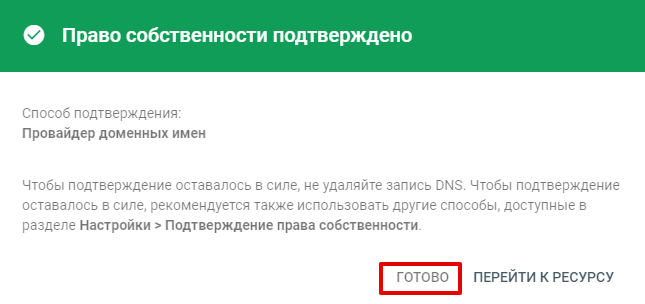

-

4

Если права подтверждены корректно, вы увидите уведомление. Нажмите Готово:

Готово, вы ускорили индексацию сайта. Теперь вы знаете, как добавить сайт в поисковики.

Обратите внимание

Описанный способ не требует технических навыков и знания SEO-оптимизации, но не гарантирует, что сайт сразу появится в поисковой выдаче. Если вы технически подкованы, воспользуйтесь другим способом: Как добавить сайт в Google?.

Мы рассказали о том, как зарегистрировать сайт в Яндексе и Гугле и добавить сайт в поисковые системы бесплатно. Это поможет вам на начальном этапе. Если вы хотите продвигать свой ресурс, рекомендуем также подключить SSL-сертификат. Он поможет в SEO-продвижении проекта: позволит занять более высокую позицию в поисковой выдаче. В Рег.ру вы можете заказать бесплатный SSL-сертификат для домена на 1 год: Как заказать бесплатный SSL-сертификат?

Помогла ли вам статья?

Спасибо за оценку. Рады помочь 😊

Как склеить сайты

В статье мы расскажем, как сделать склейку сайта с «www» и без «www».

Склейка сайта с «www»/без «www»

Склейка — объединение нескольких сайтов в один для корректной индексации в поисковых системах. Чтобы склеить сайт (mysite.ru) c псевдонимом (www.mysite.ru), настройте 301 редирект с «www.mysite.ru» (основного зеркала) на «mysite.ru»:

- Как настроить переадресацию на домен БЕЗ «www»? (для хостинга на Linux);

- Редирект через web.config (хостинг для ASP.NET).

Также вы можете воспользоваться встроенным инструментом Яндекс: Переезд сайта.

Склейка разных сайтов

Для индексации в Яндекс Для индексации в Google

Чтобы настроить склейку доменов при переносе сайта с одного домена (old-site.ru) на другой (new-site.old), воспользуйтесь справкой Яндекс:

Склейка сайтов происходит в течение 1-2 месяцев.

Для индексации в Google необходимо установить 301 редирект со старого сайта (old-site.ru) на новый (new-site.ru). Необходимо, чтобы сайты были идентичны. Как установить редирект:

Помогла ли вам статья?

Спасибо за оценку. Рады помочь 😊

Как настроить robots.txt

«robots.txt» — это специальный файл, позволяющий настроить порядок индексирования вашего сайта поисковыми роботами.

Вот некоторые настройки, которые можно произвести при помощи «robots.txt»:

- закрыть от индексирования определенные страницы сайта;

- запретить индексацию для конкретных роботов или вовсе закрыть сайт от индексации;

- задать время (интервал) посещения страницы вашего сайта поисковыми роботами.

Настройка robots.txt

Файл «robots.txt» необходимо размещать в каталоге сайта. Если файла не существует, просто создайте его.

Как задать временной интервал обращения поисковых роботов?

Задать временной интервал обращения можно на странице Индексирование — Скорость обхода в Яндекс.Вебмастере. Подробнее читайте на странице справки Яндекса.

Обратите внимание:

— снижать скорость обхода сайта роботом нужно только в том случае, если создается избыточная нагрузка на сервер. В других случаях менять параметр не требуется;

— снижение скорости обхода сайта роботом не влияет на поисковую выдачу в Яндексе.

Как закрыть индексацию папки, URL?

# закрываем индексацию страницы vip.html для Googlebot:

User-agent: Googlebot

Disallow: /vip.html

# закрываем индексацию папки private всеми роботами:

User-agent: *

Disallow: /private/

# разрешаем доступ только к страницам, начинающимся с '/shared' для Yandexbot

User-agent: Yandex

Disallow: /

Allow: /sharedДиректива «User-agent» определяет, для какого робота будут работать правила. Можно указать названия конкретных роботов, а можно задать правило для всех роботов.

Как полностью закрыть сайт от индексации?

Для запрета индексации вашего сайта всеми поисковыми роботами добавьте в файл «robots.txt» следующие строки:

User-agent: *

Disallow: /Примечание

Не все поисковые роботы следуют правилам в «robots.txt». Так, например, «Googlebot» следует запрещающим правилам («Disallow»), но не следует директиве «Crawl-delay». Ограничивать «Googlebot» необходимо через Инструменты для веб-мастеров Google.

Справка Google: О файлах robots.txt

Для робота «YandexBot» максимально возможное ограничение через «robots.txt» составляет 2 секунды. Чтобы указать нужную частоту, с которой робот будет индексировать ваш сайт, воспользуйтесь Яндекс.Вебмастером.

Справка Yandex: Использование robots.txt

Помогла ли вам статья?

Спасибо за оценку. Рады помочь 😊

Файл robots.txt для WordPress

Рассмотрим, зачем нужен файл robots.txt для WordPress, где он находится на хостинге и как настроить правильный robots.txt для WordPress.

Для чего нужен файл robots.txt?

Для того чтобы сайт начал отображаться в Яндекс, Google, Yahoo и других поисковых системах (ПС), они должны внести его страницы в свои каталоги. Этот процесс называется индексацией.

Чтобы проиндексировать тот или иной веб-ресурс, поисковые системы посылают на сайты поисковых роботов (иногда их называют ботами). Они методично сканируют и обрабатывают содержимое каждой страницы сайта. После окончания индексации начинается «социальная жизнь» ресурса: его контент попадается пользователям в результатах поиска по запросам.

Многие сайты создаются на готовых движках и CMS (системах управления контентом) WordPress, Joomla, Drupal и других. Как правило, такие системы содержат страницы, которые не должны попадать в поисковую выдачу:

- временные файлы (tmp);

- личные данные посетителей (private);

- служебные страницы (admin);

- результаты поиска по сайту и т. д.

Чтобы внутренняя информация не попала в результаты поиска, ее нужно закрыть от индексации. В этом помогает файл robots.txt. Он служит для того, чтобы сообщить поисковым роботам, какие страницы сайта нужно индексировать, а какие — нет. Иными словами, robots.txt — это файл, состоящий из текстовых команд (правил), которыми поисковые роботы руководствуются при индексации сайта.

Наличие robots.txt значительно ускоряет процесс индексации. Благодаря нему в поисковую выдачу не попадают лишние страницы, а нужные индексируются быстрее.

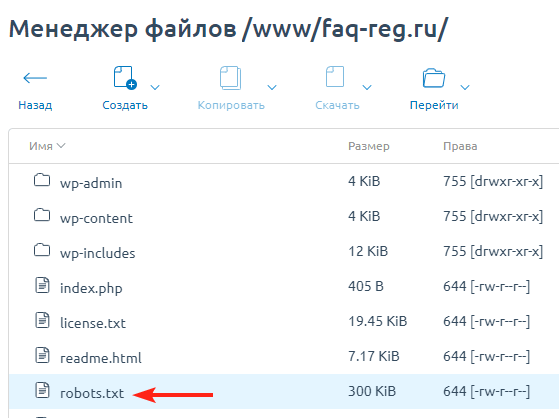

Где находится robots.txt WordPress?

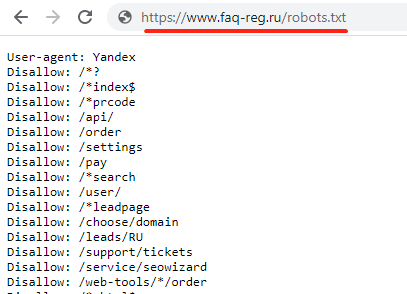

Файл robots.txt находится в корневой папке сайта. Если сайт создавался на WordPress, скорее всего, robots.txt присутствует в нем по умолчанию. Чтобы найти robots.txt на WordPress, введите в адресной строке браузера:

https://www.домен-вашего-сайта/robots.txt

- Если файл присутствует, откроется страница с перечнем правил индексации. Однако чтобы редактировать их, вам потребуется найти и открыть robots.txt на хостинге. Как правило, он находится в корневой папке сайта:

- Если же файл robots.txt по какой-то причине отсутствует, вы можете создать его вручную на своем компьютере и загрузить на хостинг или воспользоваться готовыми решениями (плагинами WordPress).

Как создать файл robots.txt для WordPress?

Есть два способа создания robots.txt:

-

1.

Вручную на компьютере.

-

2.

С помощью плагинов в WordPress.

Первый способ прост лишь на первый взгляд. После создания пустого документа и загрузки его на сайт, вы должны будете наполнить его содержанием (директивами). Ниже мы расскажем об основных правилах, однако стоит учитывать, что тонкая настройка требует специальных знаний SEO-оптимизации.

Создание robots.txt вручную

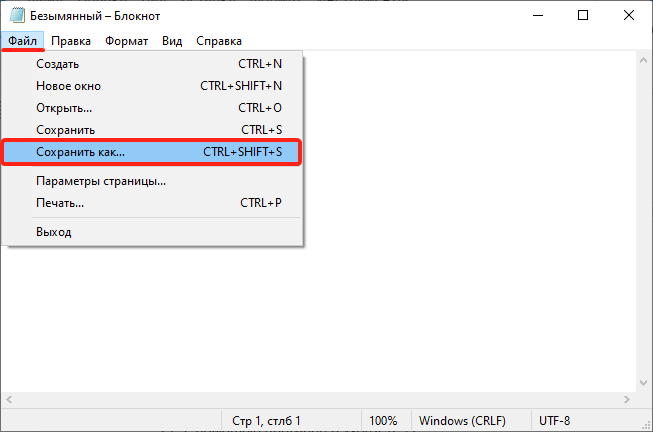

- 1 Откройте программу «Блокнот».

-

2

Нажмите Файл → Сохранить как… (или комбинацию клавиш Ctrl + Shift + S):

-

3

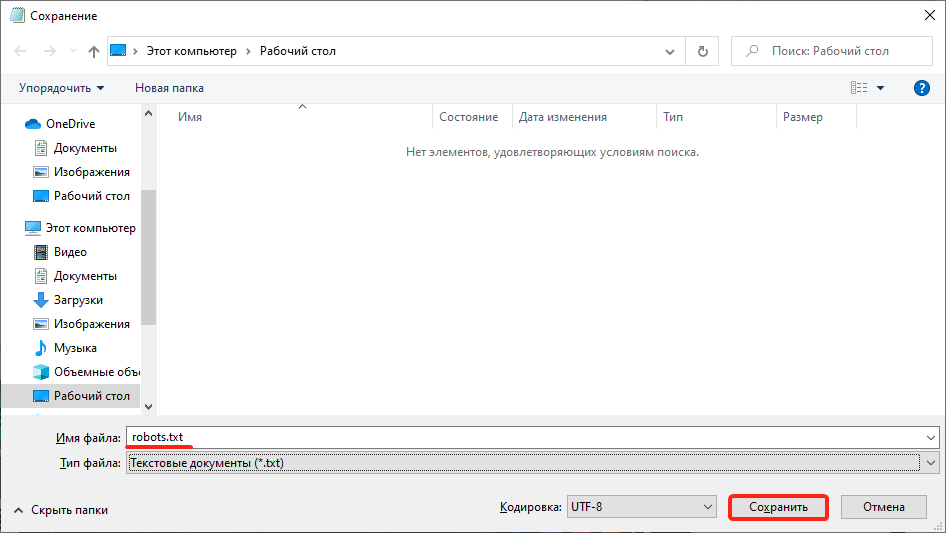

Введите название robots.txt и нажмите Сохранить.

-

4

Откройте корневую папку сайта и загрузите в нее созданный файл по инструкции.

Готово, вы разместили пустой файл и после этого сможете редактировать его прямо в панели управления хостингом.

Создание robots.txt с помощью плагина

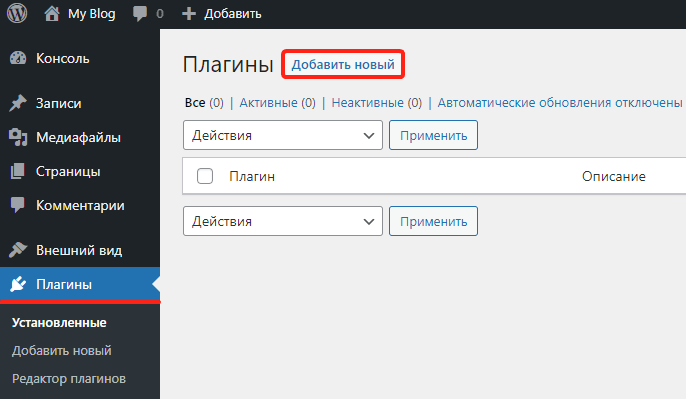

- 1 Откройте административную панель WordPress по инструкции.

-

2

Перейдите в раздел «Плагины» и нажмите Добавить новый:

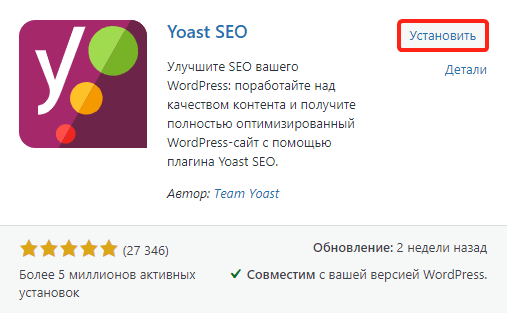

- 3 Введите в строке поиска справа название Yoast SEO и нажмите Enter.

-

4

Нажмите Установить → Активировать:

-

5

Перейдите к настройкам плагина, выбрав в меню SEO → Инструменты. Затем нажмите Редактор файлов:

-

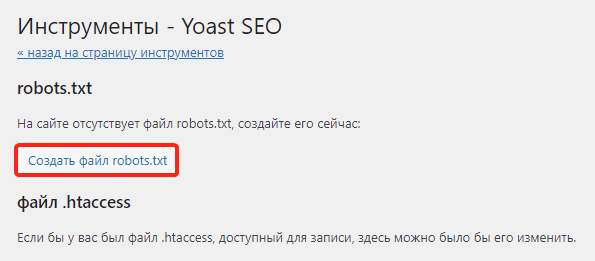

6

Нажмите Создать файл robots.txt:

-

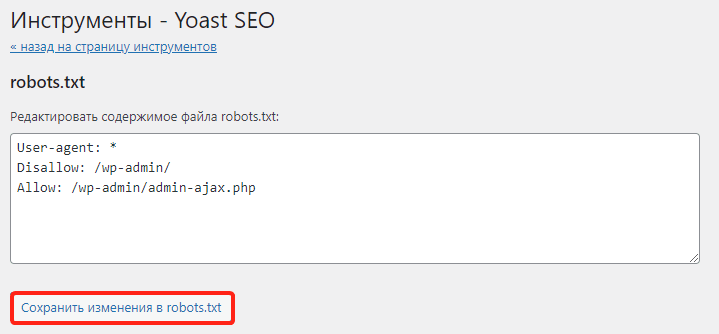

7

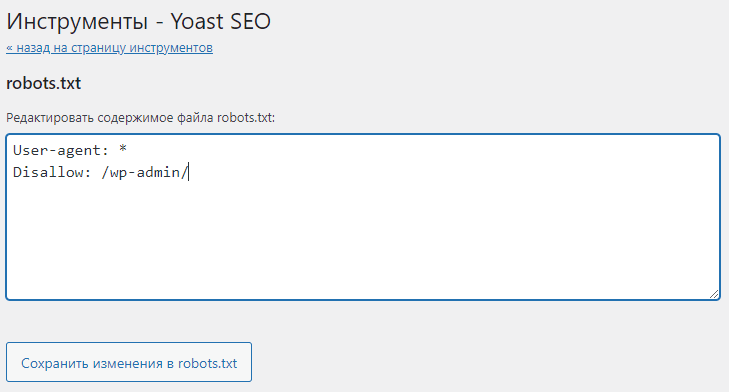

Нажмите Сохранить изменения в robots.txt:

Готово, файл с минимальным количеством директив будет создан автоматически.

Настройка robots.txt WordPress

После создания файла вам предстоит настроить robots.txt для своего сайта. Рассмотрим основы синтаксиса (структуры) этого файла:

- Файл может состоять из одной и более групп директив (правил).

- В каждой группе должно указываться, для какого поискового робота предназначены правила, к каким разделам/файлам у него нет доступа, а к какому — есть.

- Правила читаются поисковыми роботами по порядку, сверху вниз.

- Файл чувствителен к регистру, поэтому если название раздела или файла задано капслоком (например, FILE.PDF), именно так стоит писать и в robots.txt.

- Все правила одной группы должны следовать без пропуска строк.

- Чтобы оставить комментарий, нужно прописать шарп (#) в начале строки.

Все правила в файле задаются через двоеточие. Например:

User-agent: GooglebotГде User-agent — команда (директива), а Googlebot — значение.

Основные директивы и их значения

User-agent — эта директива указывает, на каких поисковых роботов распространяются остальные правила в документе. Она может принимать следующие значения:

- User-agent: * — общее правило для всех поисковых систем;

- User-agent: Googlebot — робот Google;

- User-agent: Yandex — робот Яндекс;

- User-agent: Mai.ru — робот Mail.ru;

- User-agent: Yahoo Slurp — робот Yahoo и др.

У крупнейших поисковых систем Яндекс и Google есть десятки роботов, предназначенных для индексации конкретных разделов и элементов сайтов. Например:

- YandexBot — для органической выдачи;

- YandexDirect — для контекстной рекламы;

- YandexNews — для новостных сайтов и т. п.

Для решения некоторых специфических задач веб-разработчики могут обращаться к конкретным поисковым роботам и настраивать правила исключительно для них.

Disallow — это директива, которая указывает, какие разделы или страницы нельзя посещать поисковым роботам. Все значения задаются в виде относительных ссылок (то есть без указания домена). Основные правила запрета:

- Disallow: /wp-admin — закрывает админку сайта;

- Disallow: /cgi-bin — запрет индексации директории, в которой хранятся CGI-скрипты;

- Disallow: /*? или Disallow: /search — закрывает от индексации поиск на сайте;

- Disallow: *utm* — закрывает все страницы с UTM-метками;

- Disallow: */xmlrpc.php — закрывает файл с API WordPress и т. д.

Вариантов того, какие файлы нужно закрывать от индексации, очень много. Вносите значения аккуратно, чтобы по ошибке не указать контентные страницы, что повредит поисковой позиции сайта.

Allow — это директива, которая указывает, какие разделы и страницы должны проиндексировать поисковые роботы. Как и с директивой Disallow, в значении нужно указывать относительные ссылки:

- Allow: /*.css или Allow: *.css — индексировать все css-файлы;

- Allow: /*.js — обходить js-файлы;

- Allow: /wp-admin/admin-ajax.php — разрешает индексацию асинхронных JS-скриптов, которые используются в некоторых темах.

В директиве Allow не нужно указывать все разделы и файлы сайта. Проиндексируется всё, что не было запрещено директивой Disallow. Поэтому задавайте только исключения из правила Disallow.

Sitemap — это необязательная директива, которая указывает, где находится карта сайта Sitemap. Единственная директива, которая поддерживает абсолютные ссылки (то есть местоположение файла должно указываться целиком): Sitemap: https://site.ru/sitemap.xml , где site.ru — имя домена.

Также есть некоторые директивы, которые считаются уже устаревшими. Их можно удалить из кода, чтобы не «засорять» файл:

- Crawl-delay. Задает паузу в индексации для поисковых роботов. Например, если задать для Crawl-Delay параметр 2 секунды, то каждый новый раздел/файл будет индексироваться через 2 секунды после предыдущего. Это правило раньше указывали, чтобы не создавать дополнительную нагрузку на хостинг. Но сейчас мощности современных процессоров достаточно для любой нагрузки.

- Host. Указывает основное зеркало сайта. Например, если все страницы сайта доступны с www и без этого префикса, один из вариантов будет считаться зеркалом. Главное — чтобы на них совпадал контент. Раньше зеркало нужно было задавать в robots.txt, но сейчас поисковые системы определяют этот параметр автоматически.

- Clean-param. Директива, которая использовалась, чтобы ограничить индексацию совпадающего динамического контента. Считается неэффективной.

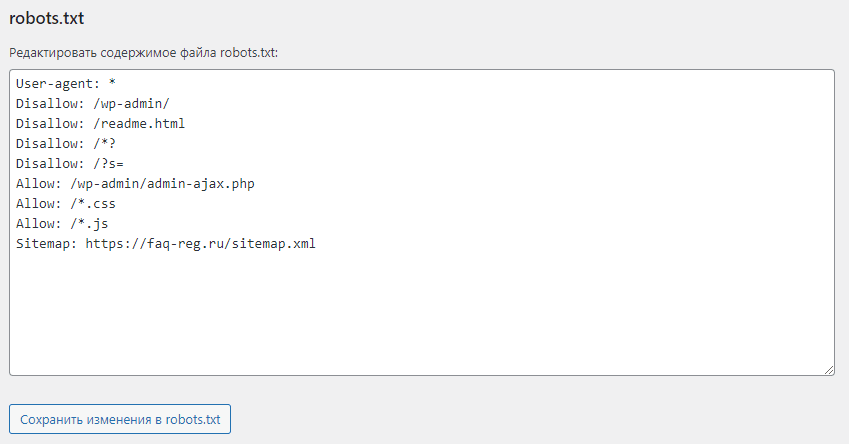

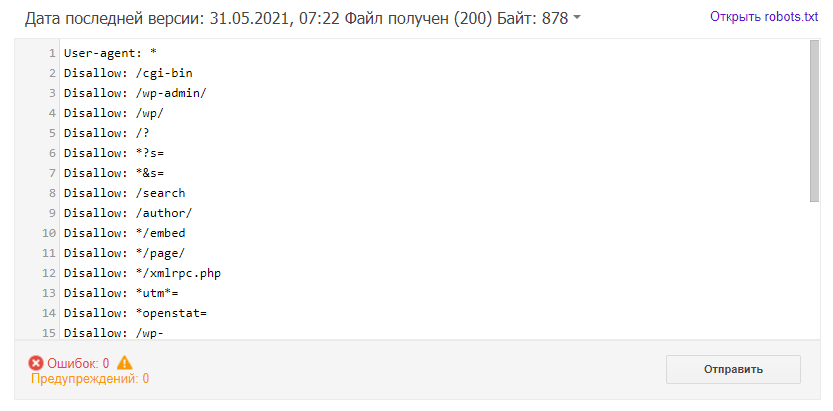

Пример robots.txt

Рассмотрим стандартный файл robots.txt, который можно скопировать и использовать для блога, заменив название домена в директиве Sitemap и убрав комментарии (текст справа, включая #):

User-agent: * # общие правила для всех поисковых роботов

Disallow: /wp-admin/ # запретить индексацию папки wp-admin (все служебные папки)

Disallow: /readme.html # закрыть доступ к стандартному файлу о программном обеспечении

Disallow: /*? # запретить индексацию результатов поиска по сайту

Disallow: /?s= # запретить все URL поиска по сайту

Allow: /wp-admin/admin-ajax.php # индексировать асинхронные JS-файлы темы

Allow: /*.css # индексировать CSS-файлы

Allow: /*.js # индексировать JS-скрипты

Sitemap: https://site.ru/sitemap.xml # указать местоположение карты сайтаКак редактировать robots.txt на WordPress?

Чтобы внести изменения в файл robots.txt, откройте его в панели управления хостингом. Используйте плагин Yoast SEO (или аналогичное решение в WordPress) для редактирования файлов:

Проверка работы файла robots.txt

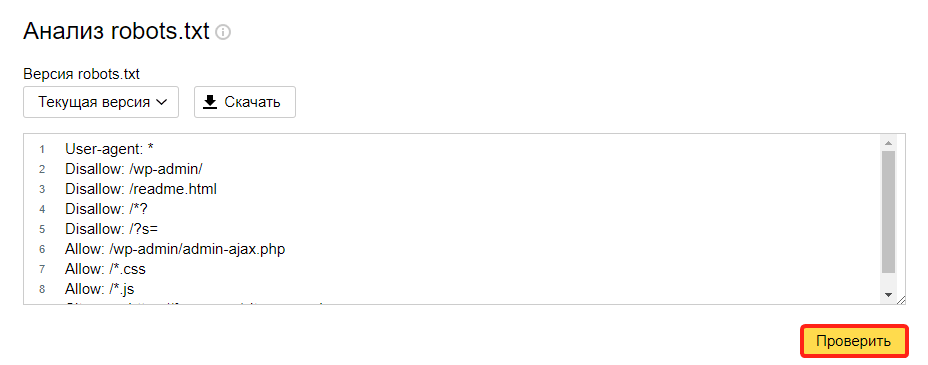

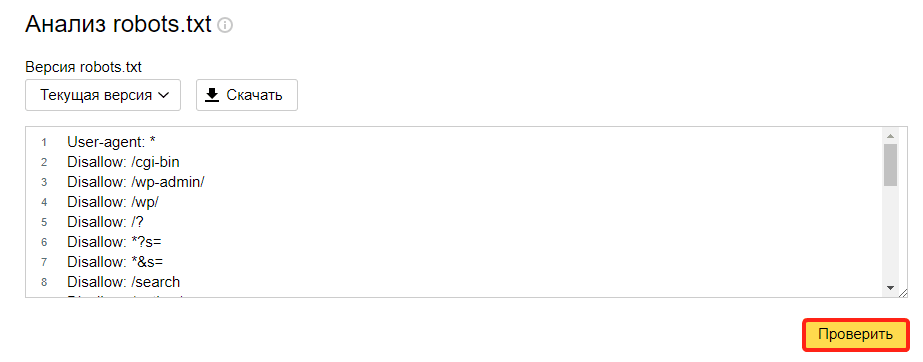

Чтобы убедиться в корректности составленного файла, используйте стандартный инструмент Яндекс.Вебмастер:

- 1 Откройте страницу.

- 2 Перейдите в раздел Инструменты → Анализ robots.txt.

-

3

Содержимое robots.txt обновится автоматически. Нажмите Проверить:

Если в синтаксисе файла будут ошибки, Яндекс укажет, в каких строчках проблема и даст рекомендации по исправлению.

Помогла ли вам статья?

Спасибо за оценку. Рады помочь 😊

Проверка файла robots.txt

Файл robots.txt — это инструкция для поисковых роботов. В ней указывается, какие разделы и страницы сайта могут посещать роботы, а какие должны пропускать. В фокусе этой статьи — проверка robots.txt. Мы рассмотрим советы по созданию файла для начинающих веб-разработчиков, а также разберем, как делать анализ robots.txt с помощью стандартных инструментов Яндекс и Google.

Зачем нужен robots.txt

Поисковые роботы — это программы, которые сканируют содержимое сайтов и заносят их в базы поисковиков Яндекс, Google и других систем. Этот процесс называется индексацией.

robots.txt содержит информацию о том, какие разделы нельзя посещать поисковым роботам. Это нужно для того, чтобы в выдачу не попадало лишнее: служебные и временные файлы, формы авторизации и т. п. В поисковой выдаче должен быть только уникальный контент и элементы, необходимые для корректного отображения страниц (изображения, CSS- и JS-код).

Если на сайте нет robots.txt, роботы заходят на каждую страницу. Это занимает много времени и уменьшает шанс того, что все нужные страницы будут проиндексированы корректно.

Если же файл есть в корневой папке сайта на хостинге, роботы сначала обращаются к прописанным в нём правилам. Они узнают, куда нельзя заходить, а какие страницы/разделы обязательно нужно посетить. И только после этого начинают обход сайта по инструкции.

Веб-разработчикам следует создать файл, если его нет, и наполнить его правильными директивами (командами) для поисковых роботов. Ниже кратко рассмотрим основные директивы для robots.txt.

Основные директивы robots.txt

Структура файла robots.txt выглядит так:

- 1. Директива User-agent. Обозначает, для каких поисковых роботов предназначены правила в документе. Здесь можно указать все поисковые системы (для этого используется символ «*») или конкретных роботов (Yandex, Googlebot и другие).

- 2. Директива Disallow (запрет индексации). Указывает, какие разделы не должны сканировать роботы. Даже если на сайте нет служебного контента, который необходимо закрыть от индексации, директиву нужно прописывать (не указывая значение). Если не сделать этого, robots.txt может некорректно читаться поисковыми роботами.

- 3. Директива Allow (разрешение). Указывает, какие разделы или файлы должны просканировать поисковые роботы. Здесь не нужно указывать все разделы сайта: все, что не запрещено к обходу, индексируется автоматически. Поэтому следует задавать только исключения из правила Disallow.

- 4. Sitemap (карта сайта). Полная ссылка на файл в формате .xml. Sitemap содержит список всех страниц, доступных для индексации, а также время и частоту их обновления.

Пример простого файла robots.txt (после # указаны пояснительные комментарии к директивам):

User-agent: * # правила ниже предназначены для всех поисковых роботов

Disallow: /wp-admin # запрет индексации служебной папки со всеми вложениями

Disallow: /*? # запрет индексации результатов поиска на сайте

Allow: /wp-admin/admin-ajax.php # разрешение индексации JS-скрипты темы WordPress

Allow: /*.jpg # разрешение индексации всех файлов формата .jpg

Sitemap: http://site.ru/sitemap.xml # адрес карты сайта, где вместо site.ru — домен сайтаСоветы по созданию robots.txt

Для того чтобы файл читался поисковыми программами корректно, он должен быть составлен по определенным правилам. Даже детали (регистр, абзацы, написание) играют важную роль. Рассмотрим несколько основных советов по оформлению текстового документа.

Группируйте директивы

Если требуется задать различные правила для отдельных поисковых роботов, в файле нужно сделать несколько блоков (групп) с правилами и разделить их пустой строкой. Это необходимо, чтобы не возникало путаницы и каждому роботу не нужно было сканировать весь документ в поисках подходящих инструкций. Если правила сгруппированы и разделены пустой строкой, робот находит нужную строку User-agent и следует директивам. Пример:

User-agent: Yandex # правила только для ПС Яндекс

Disallow: # раздел, файл или формат файлов

Allow: # раздел, файл или формат файлов

# пустая строка

User-agent: Googlebot # правила только для ПС Google

Disallow: # раздел, файл или формат файлов

Allow: # раздел, файл или формат файлов

Sitemap: # адрес файлаУчитывайте регистр в названии файла

Для некоторых поисковых систем не имеет значение, какими буквами (прописными или строчными) будет обозначено название файла robots.txt. Но для Google, например, это важно. Поэтому желательно писать название файла маленькими буквами, а не Robots.txt или ROBOTS.TXT.

Не указывайте несколько каталогов в одной директиве

Для каждого раздела/файла нужно указывать отдельную директиву Disallow. Это значит, что нельзя писать Disallow: /cgi-bin/ /authors/ /css/ (указаны три папки в одной строке). Для каждой нужно прописывать свою директиву Disallow:

Disallow: /cgi-bin/

Disallow: /authors/

Disallow: /css/Убирайте лишние директивы

Часть директив robots.txt считается устаревшими и необязательными: Host (зеркало сайта), Crawl-Delay (пауза между обращением поисковых роботов), Clean-param (ограничение дублирующегося контента). Вы можете удалить эти директивы, чтобы не «засорять» файл.

Как проверить robots.txt онлайн

Чтобы убедиться в том, что файл составлен грамотно, можно использовать веб-инструменты Яндекс, Google или онлайн-сервисы (PR-CY, Website Planet и т. п.). В Яндекс и Google есть собственные правила для проверки robots.txt. Поэтому файл необходимо проверять дважды: и в Яндекс, и в Google.

Яндекс.Вебмастер

Если вы впервые пользуетесь сервисом Яндекс.Вебмастер, сначала добавьте свой сайт и подтвердите права на него. После этого вы получите доступ к инструментам для анализа SEO-показателей сайта и продвижения в ПС Яндекс.

Чтобы проверить robots.txt с помощью валидатора Яндекс:

- 1 Зайдите в личный кабинет Яндекс.Вебмастер.

- 2 Выберите в левом меню раздел Инструменты → Анализ robots.txt.

-

3

Содержимое нужного файла подставиться автоматически. Если по какой-то причине этого не произошло, скопируйте код, вставьте его в поле и нажмите Проверить:

проверка robotstxt 1

-

4

Ниже будут указаны результаты проверки. Если в директивах есть ошибки, сервис покажет, какую строку нужно поправить, и опишет проблему:

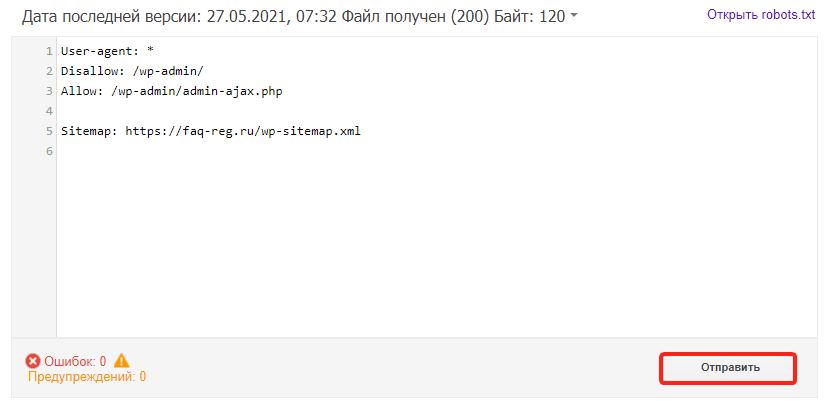

Google Search Console

Чтобы сделать проверку с помощью Google:

- 1 Перейдите на страницу инструмента проверки.

-

2

Если на открывшейся странице отображается неактуальная версия robots.txt, нажмите кнопку Отправить и следуйте инструкциям Google:

-

3

Через несколько минут вы можете обновить страницу. В поле будут отображаться актуальные директивы. Предупреждения/ошибки (если система найдет их) будут перечислены под кодом.

Проверка robots.txt Google не выявила ошибок

Обратите внимание: правки, которые вы вносите в сервисе проверки, не будут автоматически применяться в robots.txt. Вам нужно внести исправленный код вручную на хостинге или в административной панели CMS и сохранить изменения.

Помогла ли вам статья?

Спасибо за оценку. Рады помочь 😊

Лучшие сервисы для анализа сайтов онлайн

Насколько сайт популярен? Одинаково ли он выглядит на разных устройствах и в разных браузерах? Хорошо ли SEO-оптимизирован ресурс? Как проверить сайт конкурента? Это частые вопросы владельцев веб-ресурсов.

Информация о сайте — это несекретные данные. Для онлайн-проверки сайта можно использовать десятки сервисов, которые ответят на все вопросы, связанные с аудитом сайта. Некоторые из них мы рассмотрим в статье.

Для чего может понадобится узнать всё о сайте:

- 1. Для аудита своего сайта, чтобы увидеть слабые места веб-ресурса. Страница может плохо отображаться на мобильных устройствах, долго загружаться или содержать битые ссылки. Лучше решить эти проблемы раньше, чем это заметят пользователи и поисковые системы.

- 2. Для изучения конкурентов. Конкуренция в интернете растёт, и нужно постоянно следить за своими соперниками, ведь чем они сильнее, тем ваш сайт ниже в поисковой выдаче. Возможно, ресурсу не хватает SEO-оптимизации или есть проблема с контентом. Это можно будет узнать в сравнении с конкурентами.

- 3. Для анализа сайта при его покупке. Необязательно делать сайт с нуля. Можно приобрести готовый ресурс со схожей тематикой у другого владельца. Чтобы не купить сайт с плохой репутацией, перед покупкой нужно провести небольшой анализ сайта. На репутацию может влиять некачественный контент, плагиат, плохая SEO-оптимизация, навязчивая реклама.

- 4. Для заказа рекламы. Реклама ― это эффективный метод продвижения любого ресурса. Однако важно, чтобы она располагалась на популярных и качественных сайтах.

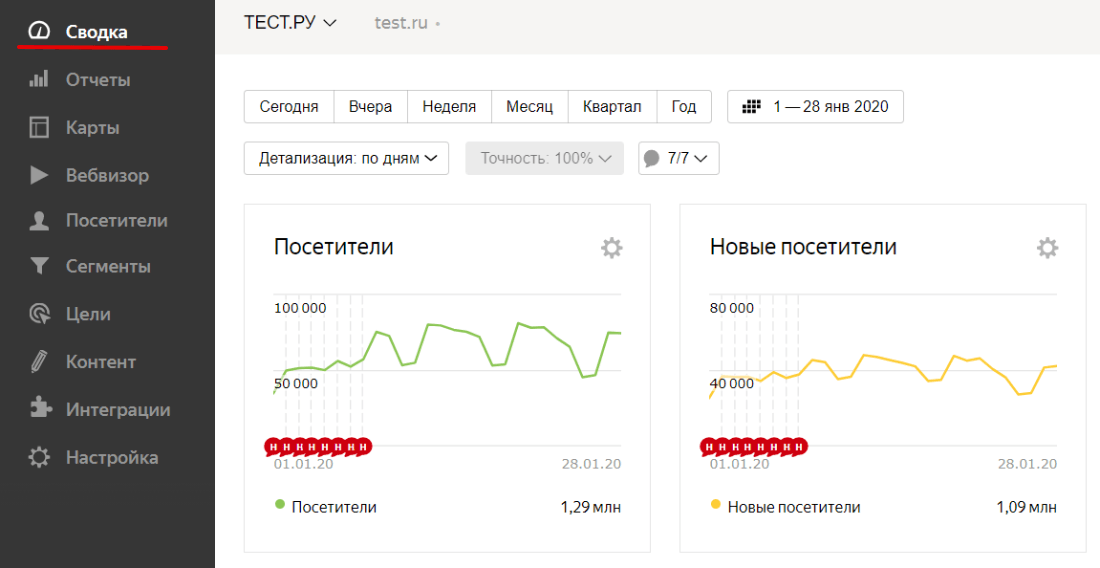

Посещаемость сайта

Посещаемость показывает, насколько сайт отвечает потребностям целевой аудитории. Также посещаемость важна при выборе платформы для рекламы. Чем популярнее ресурс, тем целесообразнее размещать на нём рекламу.

Если вы владелец веб-ресурса, то проверить посещаемость можно с помощью сервисов Яндекс.Метрика и Google Аналитика.

- 1 Зарегистрируйтесь на сервисе и прикрепите к нему свой сайт.

-

2

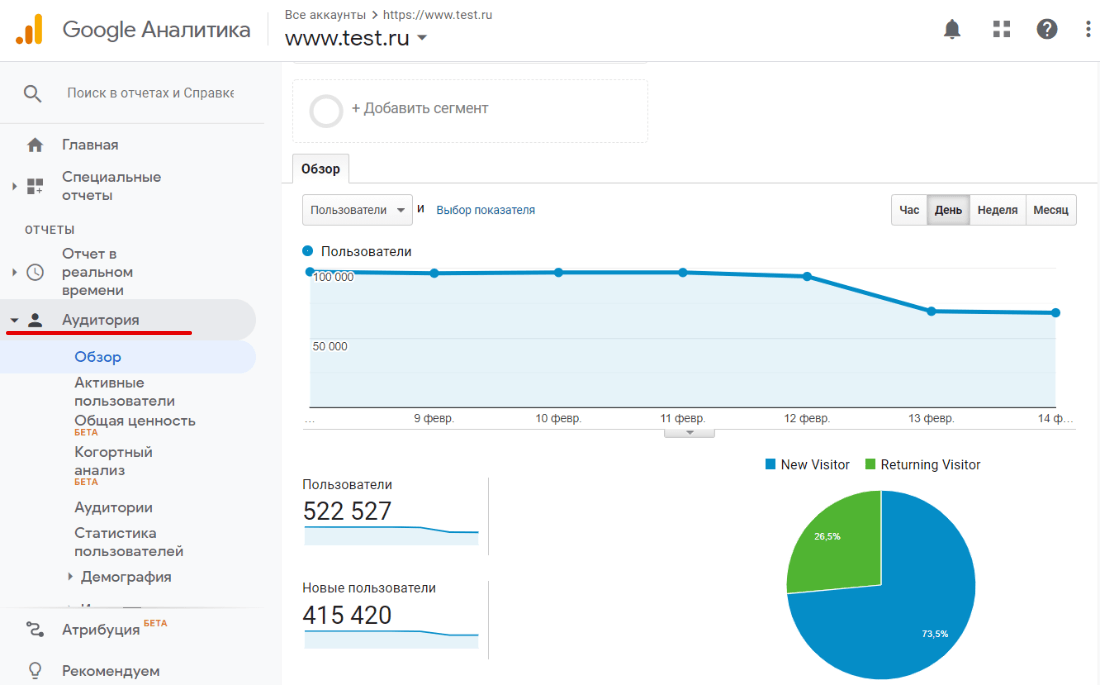

Перейдите во вкладку Сводка. Здесь вы увидите количество новых пользователе и общее число посетителей:

- 1 Зарегистрируйтесь на сервисе и прикрепите свой сайт к нему.

-

2

Перейдите во вкладку Аудитория. Здесь можно не только посмотреть общее количество посетителей, но и увидеть количество активных пользователей, а также длительность их контакта с сайтом:

Если вас интересует посещаемость не вашего сайта, то можно воспользоваться программой SimilarWeb. Этот сервис сотрудничают с браузерами, поэтому он располагает данными о посетителях сайта. Однако эти данные только приблизительные. Точные цифры может знать только администратор. Для оценки со стороны этого достаточно, так как погрешность небольшая.

Посещаемость сайта важна для SEO-анализа, поэтому этот показатель входит во многие отчёты сервисов для анализа на SEO-оптимизацию. Если вас интересует не только посещаемость, но и полная проверка сайта, используйте один из сервисов, описанных ниже.

Лучшие инструменты для онлайн-анализа SEO сайта

SEO ― совокупность работ, которая направлена на повышение позиций сайта в поисковой выдаче. Чем выше сайт в выдаче поиска, тем чаще его видят пользователи и тем больше шансов привлечь потребителей на сайт.

Так же как и при изучении посещаемости, выбор сервисов для анализа зависит от того, чей сайт вы изучаете. Если вы хотите проанализировать свой сайт, то самыми популярными сервисами являются Яндекс.Вебмастер и Google Search Console. Если ваш ресурс создан на Рег.сайт, настроить базовое SEO-продвижение поможет статья Как настроить SEO-продвижение сайта, созданного в Рег.сайт.

Проанализировать сторонний ресурс помогут другие сервисы. Ниже мы сделаем обзор наиболее популярных сервисов, с помощью которых можно сделать онлайн SEO-анализ сайта бесплатно.

XTOOL

XTOOL позволяет быстро сделать комплексный SEO-анализ сайта бесплатно. С его помощью можно узнать:

✔ возраст сайта,

✔ рейтинг веб-ресурса в поисковых системах,

✔ наличие санкций на сайт,

✔ количество внутренних и внешних ссылок,

✔ показатели PR, ИКС, ТИЦ,

✔ траст.

SBUP.com

По сравнению с XTOOL SBUP.com имеет более широкий функционал. Кроме стандартных SEO-параметров (возраст, PR, ИКС и ТИЦ-показатели, ключевые слова, внутренние и внешние ссылки), он показывает:

✔ IP-адрес,

✔ тип и ПО сервера,

✔ наличие вирусов,

✔ скорость ресурса,

✔ определяет примерную цену.

PR-CY

PR-CY.RU ― один из самых популярных бесплатных сервисов, с помощью которого можно проверить оптимизацию сайта. Введите интересующий вас домен и сервис покажет вам:

✔ важные изменения, которые происходили на сайте, например изменения в файле robots.txt,

✔ ИКС, PR, позиция в Яндекс и Google,

✔ вирусы и санкции,

✔ посещаемость,

✔ рейтинг в Alexa.

В платной версии можно получить ещё больше информации:

✔ географию аудитории,

✔ источники трафика,

✔ трафик в социальных сетях,

✔ поведение пользователей (количество отказов, время на сайте, количество посещенных страниц).

SeoLik

С помощью сервиса SeoLik можно сделать полный анализ сайта по разным показателям, в том числе SEO. Чтобы запустить проверку, достаточно ввести доменное имя и нажать «Анализ». Сервис позволяет проверить:

- основные показатели в поисковых системах Google и Яндекс,

- историю запросов и позиции сайта,

- историю видимости в Google,

- кол-во обратных ссылок на сайт,

- счетчики, социальный индекс и значение Rank,

- наличие favicon,

- показатель mobile-friendly,

- уровень защиты сайта.

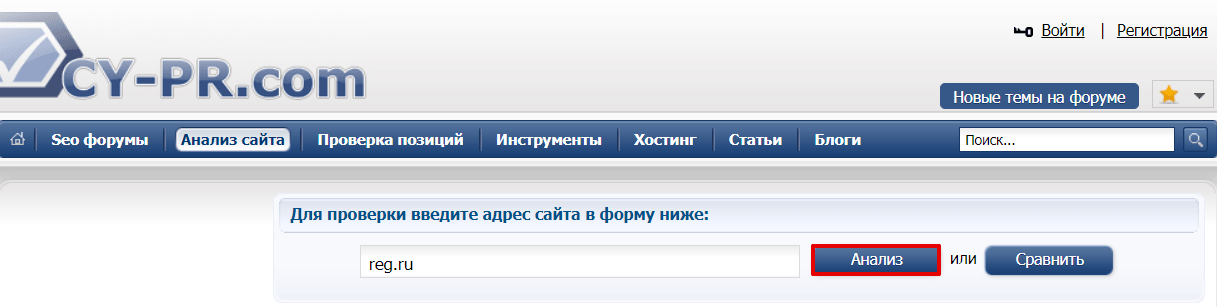

CY-PR.com

CY-PR.com ― ещё один бесплатный сервис для экспресс-анализа показателей SEO. Регистрироваться не нужно, просто введите доменное имя и нажмите Анализировать:

Он будет полезен для анализа своего сайта и для анализа конкурентов. Кроме стандартных критериев оценки, CY-PR.COM предлагает:

✔ измерение скорости работы сайта,

✔ данные из WHOIS,

✔ проверяет ошибки в кэшировании и CSS,

✔ проверяет оптимизацию для мобильных устройств и планшетов.

СайтРепорт

На saitreport.ru можно бесплатно проверить 25 страниц портала. Для использования ресурса нужна регистрация. Сервис позволяет провести технический аудит (тип и ПО сервера, наличие вирусов на сайте, скорость ресурса и т. д.), выдаёт данные о количестве страниц портала, среднем времени загрузки, наличии sitemap и robots.txt. Также можно проверить данные о контекстной рекламе, объёме поискового трафика в месяц, числе запросов в Яндекс и Google, обратных ссылках и анкорах. Есть возможность узнать количество упоминаний в СМИ и в социальных сетях. Программа оценивает корректность тегов и оригинальность контента. Можно настроить автоматическую проверку, и раз в день, неделю или месяц сервис будет отправлять результат анализа на вашу электронную почту.

Пиксель Тулс

Пиксель Тулс — универсальный анализатор сайта, который поможет узнать практически всё о ресурсе. Он простой в использовании, в бесплатной версии достаточно много инструментов для SEO-анализа. Сервис:

✔ проверяет тексты на уникальность и вхождение ключевых слов,

✔ проверяет позиции в Google и Яндекс,

✔ показывает количество переходов из социальных сетей,

✔ анализирует количество рекламных объявлений в выдаче Яндекса,

✔ рассчитывает KPI,

✔ анализирует ссылочную массу,

✔ анализирует скорость загрузки контента.

В платной версии можно получить ещё больше возможностей, таких как анализ XML-карты, проверка поведенческих факторов пользователей, анализ SEO-тегов для списка URL и др. Можно настроить автоматический аудит.

Качество кода сайта

Чистота и качество кода — важные критерии оценки работы программиста. Предполагается, что сам программист будет создавать ресурс с понятной логикой и без лишнего «мусора» либо за ним проверит ревьюер и исправит недочеты. Однако если ваш сайт создавал частный специалист, не лишним будет проверить ресурс через онлайн-сервис оценки готового кода. Например, Reshift, Review Board или Gerrit. С помощью этих сервисов можно выявить недочеты в разработке, чтобы затем отправить код на доработку. Чтобы приступить к анализу, зарегистрируйтесь.

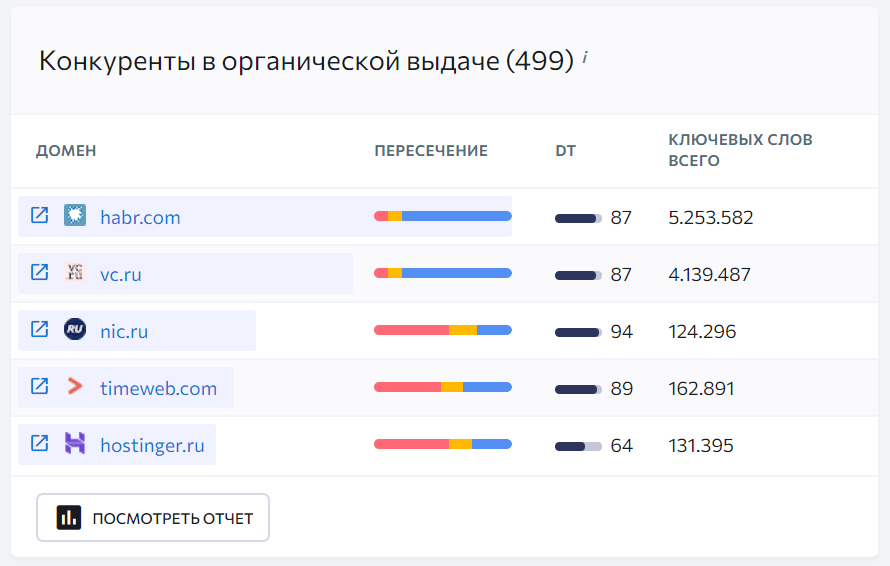

Конкуренты

Учиться на чужих ошибках выгоднее, чем на своих. Привычка анализировать конкурентов — неотъемлемая черта лидеров рынка. Анализ сайтов конкурентов помогает выявить слабые стороны своего ресурса и определить траекторию дальнейшего развития. Через сервис SE Ranking можно оценить:

- распределение позиций конкурентов по ключевым словам,

- позиции сайтов по количеству трафика и ключевым словам,

- пересечение семантик разных доменов.

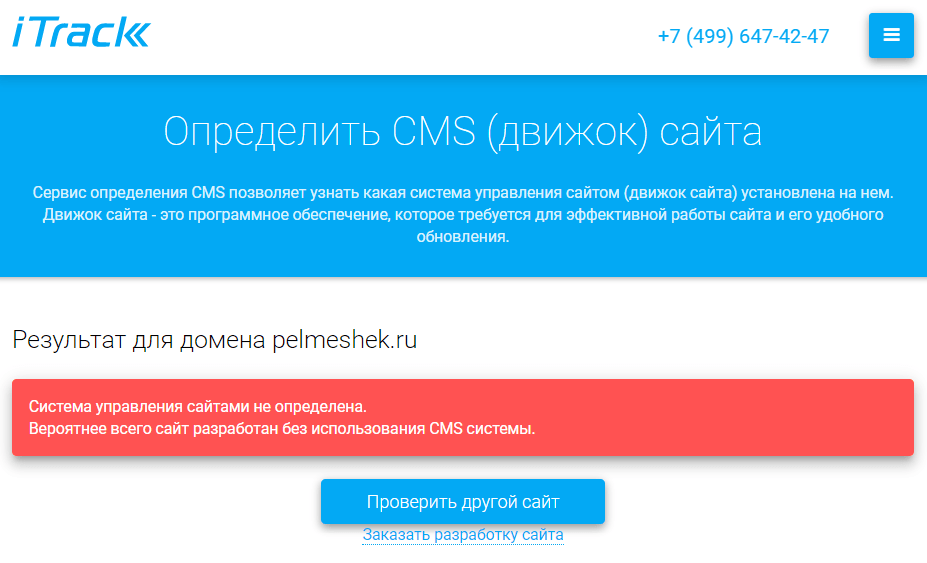

На каком движке работает ресурс

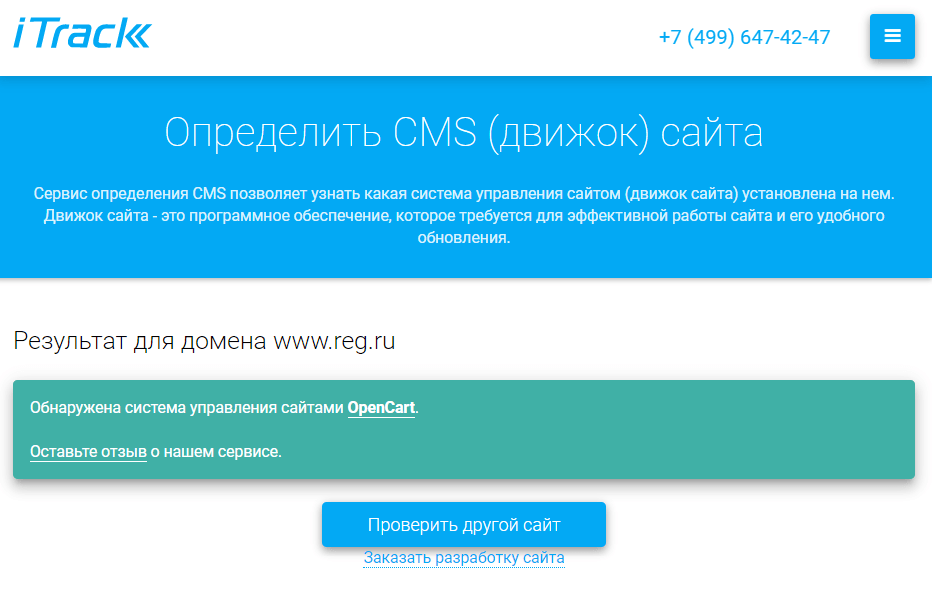

Иногда необходимо узнать, на чём был создан или написан сайт — коде или CMS. С помощью сервиса iTrack можно узнать, на чём создавался веб-ресурс. Для этого введите домен и кликните «Определить CMS». Если сайт разработан с использованием кода, программа покажет ошибку:

Если сайт создавался с помощью системы управления контентом (например, WordPress, 1С-Битрикс, Joomla, Drupal), сервис покажет, какой именно.

Совместимость с другими браузерами

Пользователи могут заходить на сайт не только с разных устройств, но и с разных браузеров. Важно, чтобы он одинаково отображался на всех платформах. Чтобы проверить отображение в разных браузерах, можно использовать Browserling. Можно посмотреть, как выглядит сайт на Internet Explorer, Chrome, Safari, Opera и Firefox.

Нарушение авторских прав

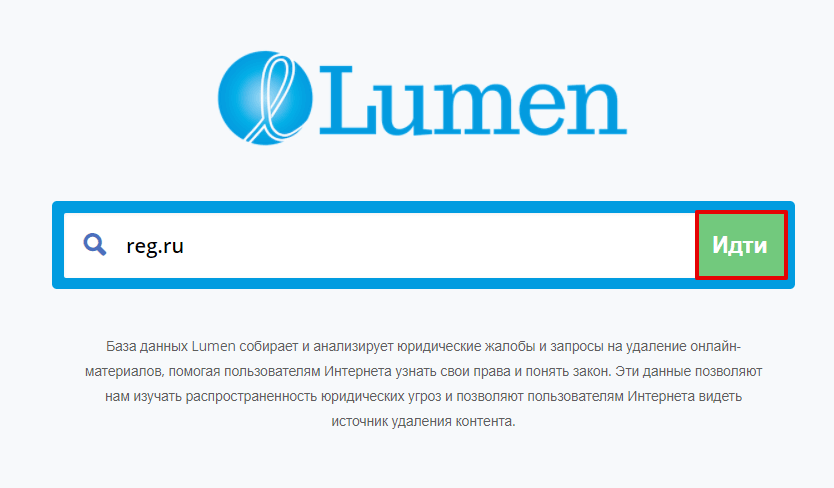

Если вы планируете купить уже использованный домен или весь сайт, обратите внимание на его репутацию. Один из способов узнать прошлое веб-ресурса ― найти жалобы на нарушение авторских прав. Если сайт активно использовал плагиат, то его рейтинг в поисковых системах явно низкий и покупать такой домен невыгодно. Проверить количество жалоб на сайт поможет Lumen. Введите доменное имя и нажмите Идти:

Перед вами появится список всех жалоб, которые получал сайт за всё время его существования.

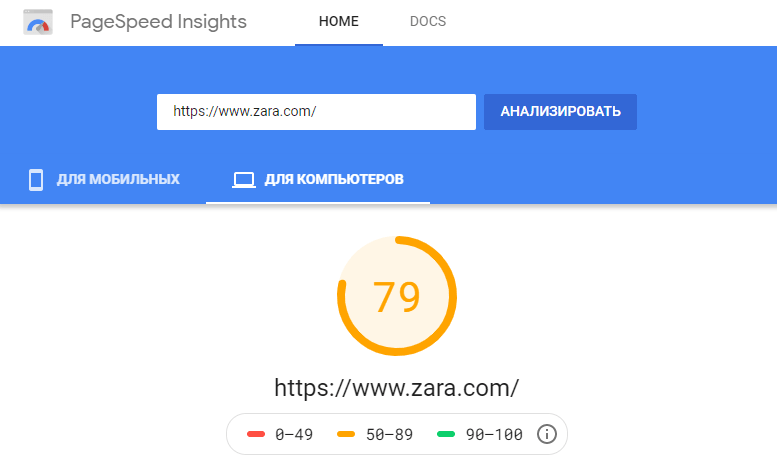

Скорость сайта

Скорость загрузки сайта ― это важный элемент, за которым нужно следить. Пользователи не любят долго ждать загрузку страницы. Поисковые системы об этом знают и размещают медленные страницы ниже в поисковой выдаче.

Сервис PageSpeed Insights от Google не только покажет скорость загрузки, но и подскажет, какие проблемы нужно устранить, чтобы сайт стал загружаться быстрее.

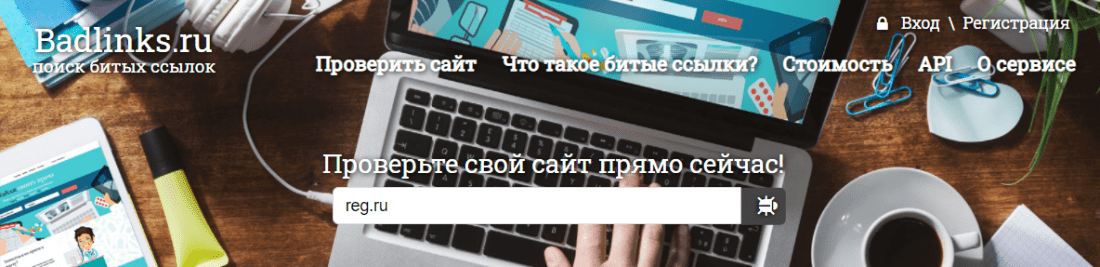

Битые ссылки

Битая ссылка — это гиперссылка с ошибкой в URL-адресе. Из-за этого пользователь не может увидеть нужную ему информацию.

Они могут появиться, если:

- старые страницы или документы были удалены,

- была изменена ссылка на стороннем сайте,

- ссылка была написана с ошибкой,

- произошли изменения в структуре сайта. Например, страница была перенесена в другой раздел и поменяла свой URL, а старые ссылки на страницу остались неизменными.

Проверить сайт на наличие битых ссылок можно вручную. Для этого нужно переходить во все существующие страницы на веб-ресурсе, нажимать на все ссылки и смотреть, на какие страницы они перенаправляют. Это долго и неудобно, поэтому этот процесс лучше автоматизировать с помощью Badlinks.

Делятся ли ссылками на сайт в социальных сетях

Популярный сайт должен быть не только интересен пользователям, но и побуждать посетителей делиться контентом страницы с другими. С помощью muckrack.com можно узнать, сколько раз и какие пользователи поделились конкретным URL-адресом.

Контент сайта

На успешность продвижения ресурcа влияет и качество контента. С помощью сервиса BADIP можно посмотреть, как организован контент на сайте: есть ли материалы категории Flash, какое соотношение Контента и HTML, кол-во картинок, атрибуты, теги и другое. Также в сервисе можно сделать полный SEO-анализ сайта.

Как сайт выглядел раньше

Если вы выбираете домен «с возрастом» на аукционе или в Магазине доменов, перед покупкой полезно проверить его историю. Обратите внимание на такие критерии, как: репутация, тематика, ссылочный профиль и нахождение в бан-листах. Почему это важно, читайте в статье Дроп-домен — что это? Выяснить как ресурс выглядел раньше можно через веб-архивы (например, archive.org). Подробнее: Как узнать дату создания сайта.

В этой статье мы разобрали лучшие онлайн-сервисы, которые помогут сделать сайт лучше или выбрать хороший веб-ресурс для покупки. Чтобы узнать всё о сайте, используйте несколько сервисов и сравнивайте результаты. Так вы сможете максимально точно определить слабые места ресурса.

Помогла ли вам статья?

Спасибо за оценку. Рады помочь 😊

Запрет индексации в robots.txt

Чтобы убрать весь сайт или отдельные его разделы и страницы из поисковой выдачи Google, Яндекс и других поисковых систем, их нужно закрыть от индексации. Тогда контент не будет отображаться в результатах поиска. Рассмотрим, с помощью каких команд можно выполнить в файле robots.txt запрет индексации.

Зачем нужен запрет индексации сайта через robots.txt

Первое время после публикации сайта о нем знает только ограниченное число пользователей. Например, разработчики или клиенты, которым компания прислала ссылку на свой веб-ресурс. Чтобы сайт посещало больше людей, он должен попасть в базы поисковых систем.

Чтобы добавить новые сайты в базы, поисковые системы сканируют интернет с помощью специальных программ (поисковых роботов), которые анализируют содержимое веб-страниц. Этот процесс называется индексацией.

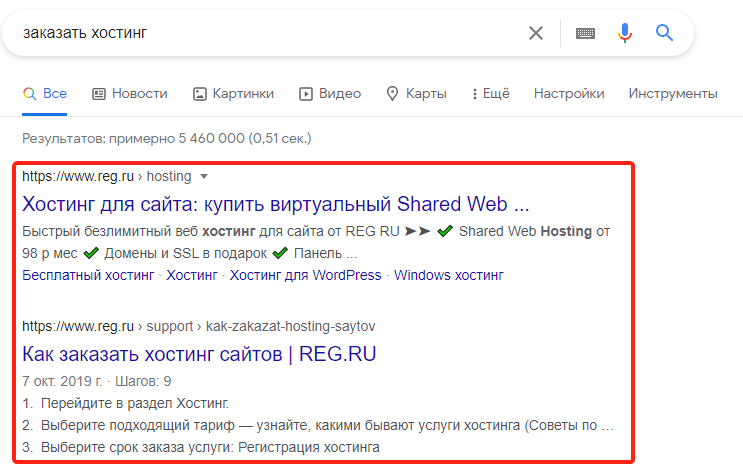

После того как впервые пройдет индексация, страницы сайта начнут отображаться в поисковой выдаче. Пользователи увидят их в процессе поиска информации в Яндекс и Google — самых популярных поисковых системах в рунете. Например, по запросу «заказать хостинг» в Google пользователи увидят ресурсы, которые содержат соответствующую информацию:

Однако не все страницы сайта должны попадать в поисковую выдачу. Есть контент, который интересен пользователям: статьи, страницы услуг, товары. А есть служебная информация: временные файлы, документация к ПО и т. п. Если полезная информация в выдаче соседствует с технической информацией или неактуальным контентом — это затрудняет поиск нужных страниц и негативно сказывается на позиции сайта. Чтобы «лишние» страницы не отображались в поисковых системах, их нужно закрывать от индексации.

Кроме отдельных страниц и разделов, веб-разработчикам иногда требуется убрать весь ресурс из поисковой выдачи. Например, если на нем идут технические работы или вносятся глобальные правки по дизайну и структуре. Если не скрыть на время все страницы из поисковых систем, они могут проиндексироваться с ошибками, что отрицательно повлияет на позиции сайта в выдаче.

Для того чтобы частично или полностью убрать контент из поиска, достаточно сообщить поисковым роботам, что страницы не нужно индексировать. Для этого необходимо отключить индексацию в служебном файле robots.txt. Файл robots.txt — это текстовый документ, который создан для «общения» с поисковыми роботами. В нем прописываются инструкции о том, какие страницы сайта нельзя посещать и анализировать, а какие — можно.

Прежде чем начать индексацию, роботы обращаются к robots.txt на сайте. Если он есть — следуют указаниям из него, а если файл отсутствует — индексируют все страницы без исключений. Рассмотрим, каким образом можно сообщить поисковым роботам о запрете посещения и индексации страниц сайта. За это отвечает директива (команда) Disallow.

Как запретить индексацию сайта

О том, где найти файл robots.txt, как его создать и редактировать, мы подробно рассказали в статье. Если кратко — файл можно найти в корневой папке. А если он отсутствует, сохранить на компьютере пустой текстовый файл под названием robots.txt и загрузить его на хостинг. Или воспользоваться плагином Yoast SEO, если сайт создан на движке WordPress.

Чтобы запретить индексацию всего сайта:

- 1 Откройте файл robots.txt.

-

2

Добавьте в начало нужные строки.

- Чтобы закрыть сайт во всех поисковых системах (действует для всех поисковых роботов):

User-agent: * Disallow: /- Чтобы запретить индексацию в конкретной поисковой системе (например, в Яндекс):

User-agent: Yandex Disallow: /- Чтобы закрыть от индексации для всех поисковиков, кроме одного (например, Google)

User-agent: * Disallow: / User agent: Googlebot Allow: / - 3 Сохраните изменения в robots.txt.

Готово. Ресурс пропадет из поисковой выдачи выбранных ПС.

Запрет индексации папки

Гораздо чаще, чем закрывать от индексации весь веб-ресурс, веб-разработчикам требуется скрывать отдельные папки и разделы.

Чтобы запретить поисковым роботам просматривать конкретный раздел:

- 1 Откройте robots.txt.

-

2

Укажите поисковых роботов, на которых будет распространяться правило. Например:

- Все поисковые системы:

User-agent: *— Запрет только для Яндекса:

User-agent: Yandex -

3

Задайте правило Disallow с названием папки/раздела, который хотите запретить:

Disallow: /catalog/Где вместо catalog — укажите нужную папку.

- 4 Сохраните изменения.

Готово. Вы закрыли от индексации нужный каталог. Если требуется запретить несколько папок, последовательно пропишите для каждой директиву Disallow.

Как закрыть служебную папку wp-admin в плагине Yoast SEO

Как закрыть страницу от индексации в robots.txt

Если нужно закрыть от индексации конкретную страницу (например, с устаревшими акциями или неактуальными контактами компании):

- 1 Откройте файл robots.txt на хостинге или используйте плагин Yoast SEO, если сайт на WordPress.

- 2 Укажите, для каких поисковых роботов действует правило.

-

3

Задайте директиву Disallow и относительную ссылку (то есть адрес страницы без домена и префиксов) той страницы, которую нужно скрыть. Например:

User-agent: * Disallow: /catalog/page.htmlГде вместо catalog — введите название папки, в которой содержится файл, а вместо page.html — относительный адрес страницы.

- 4 Сохраните изменения.

Готово. Теперь указанный файл не будет индексироваться и отображаться в результатах поиска.

Помогла ли вам статья?

Спасибо за оценку. Рады помочь 😊